はじめに

この記事は、生成AI Advent Calendar 2024へ参加させていただいています。

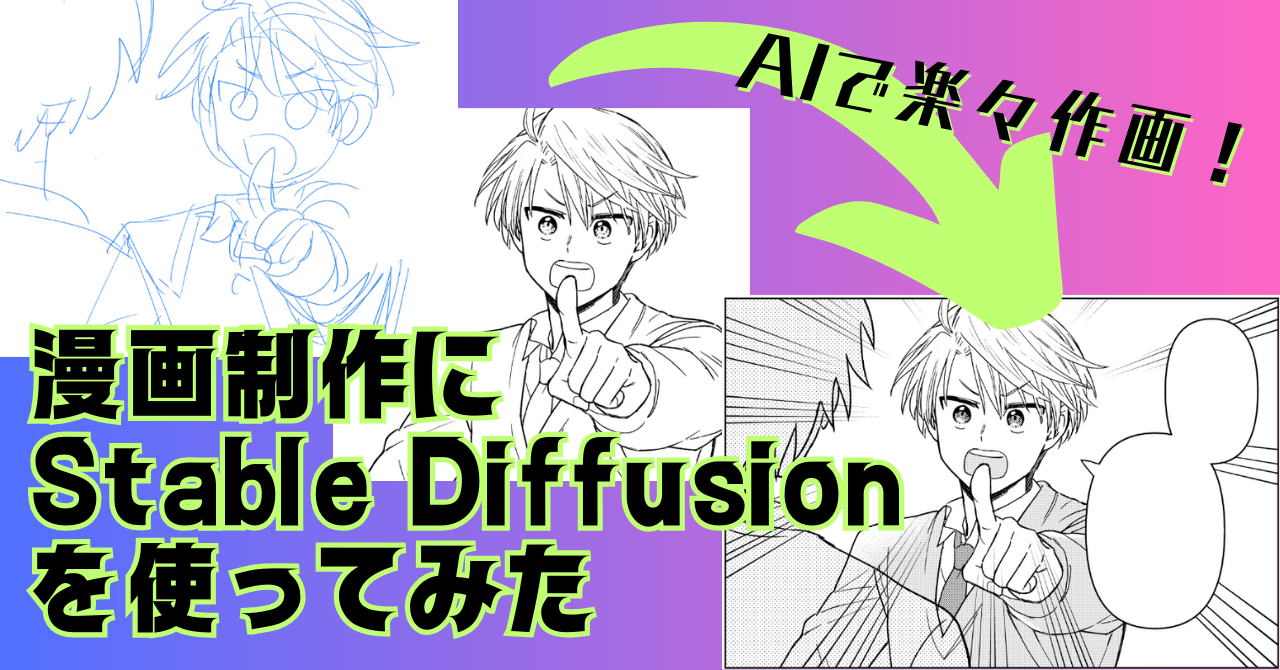

内容はタイトル通り、漫画の製作にStable Diffusionを使って楽ができたぞというものです。2024年夏ごろにしていたことで若干情報が古いですが、2024年の記録として残しておきたいと思い執筆することにしました。(でも多分この手法だと、2024年末の現在でもやれることとしてはあまり変わってないかなと思います。)

AIを活用する漫画制作のメリット・デメリット

私は20年ぐらい趣味で漫画の同人誌を描いてきました。最初の頃は良かったのですが、年月が経つにつれて絵を描くことがすごく大変になってきました。理由としては、社会人になって割ける時間が減ったこと、体力が落ちたことなどが大きいです。そこで作画に AI を使うことにしました。

AI を使うと作画が本当に楽です。完全に思い通りになるわけではないので、こだわりたいタイプには余計な手間が増えるだけかもしれません。それに、別に時短になるわけではないです。では何が楽になるかというと、自分の頭や体への負担がすごく少なくなります。

頭や体への負担の軽減

手描きで絵を描く場合、点ひとつや線に対してすら意思決定が必要で、今思えば とんでもなく頭を使う作業でした。でも AI を導入することで、それが必要なくなります。また、腕や体に力を入れなくてもある程度絵が出来上がるため、肩や背中の凝り、そこから来る腕の神経痛や腰痛などが軽減されました。

絵を描かなくていいってめちゃくちゃ楽です。疲れ方が全く違います。絵を描くのがしんどいと分かってても、今までは自分で絵を描くしか方法がなかったので、AIで楽ができるようになって感動しました。

私のように怠惰な人間じゃないとしても、AI の力を借りることで頭を使う部分を減らしつつ、クリエイティブな意思決定に集中できるということもあると思います。逆に「AI で描ける絵」を描こうとしてしまう、というデメリットはあるかもしれません。

時短にはならない

印刷用の白黒漫画原稿の場合ですが、AIを使っても制作にかかる時間はコマごとに増減があり、総合的には手描きと変わらなかったです。

ただし、フルカラーや、リッチなグレースケールの漫画であれば時短になるとは思います。

使用モデルについて

この記事で使用しているモデルは以下の通りです。

- ベースモデル:Animagine XL 3.1

- LoRA:自分絵LoRA

- ControlNet:CN-anytest_v4-marged_am_dim256

使用UIはForgeです。

anytestのダウンロードリンクはこちら

anytestは手描き勢に非常に便利なControlNetモデルです。フルカラーからの線画化・ラフからの生成・色塗りなどいろいろ使えるので、まだ試したことがない方は是非お試しください!なおAnimagine用とpony用(名前にpnとついてるのがpony用)があり、上記リンクはAnimagine用です。あとつい最近SD1.5用も追加されたみたいです。

自分絵LoRAは必須

自分絵で作ったLoRAはほぼ必須で、自分絵というだけでなく、キャラクターごとにタグをつけて学習させたものが必要だと思います。漫画ではキャラクターの一貫性がないと同じキャラクターだとなかなか認識が難しいです。しかしAIでそれをするのは難しいので、LoRAを作らないとかなり手間がかかると思います。

あとやっぱり絵柄の問題もあります。自分っぽい絵柄で漫画を作りたい。あと個人的にはデフォルメ度の調整をするのがプロンプトではすごく難しいので、それもLoRAで調整できた方がいいかなと思います。

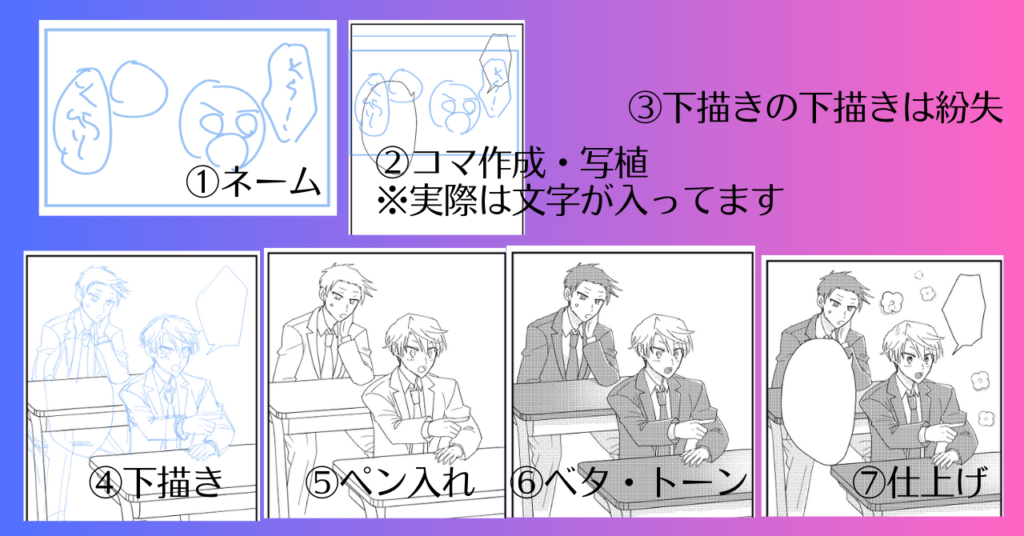

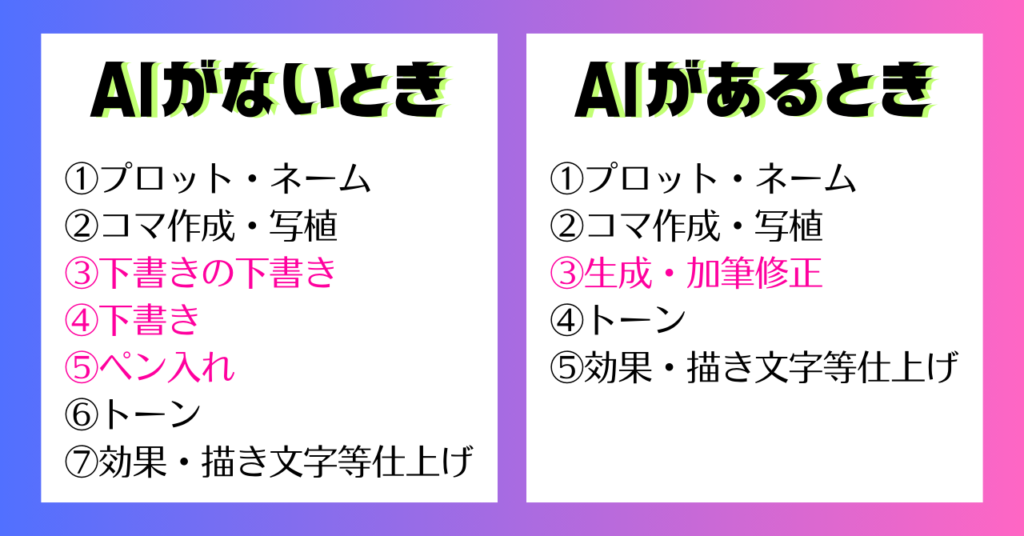

AIなしの作業プロセス

- ①プロット・ネーム

- ②コマ作成・写植

- ③下書きの下書き

- ④下書き

- ⑤ペン入れ

- ⑥トーン

- ⑦効果・描き文字等仕上げ

解決したかったこと

同じ絵を何度も描くこと

作業プロセスを見ていただいた通り、同じ絵を何回も描かないといけないです。ネーム→下描きの下描き→下描き→ペン入れ……。トーンや仕上げでもその絵をなぞることがあるし「もうええわ」って思います。それを 1コマ だけでなく、例えば 1ページ 5コマだとして、32ページだと160 コマそれをすることになります。(実際には空白のコマやセリフのみのコマもありますが。)

自分の「意図」はネームの時点で発散できているのに、それを人に伝えるためや、自分でも後から見たら意図が分からなくなってたりするので、もっと丁寧に描く必要があります。これが本当に苦しいです。ネームで気が済んでるので。でも後から読むために綺麗に描く必要がある……。

体の不調

先に述べた通り、絵を描く時には上半身全体に力が入っていたのか、肩や背中が凝って仕方がなかったです。またそのあたりが凝っていることによって、神経痛が腕に出たり、背中 の凝りによって腰痛を引き起こしたりしていました。特に描くことに意識を集中してしまうので、同じ姿勢を続けてしまうことも体に悪かったと思います。

コピペでゴリ押ししてたとき

ちなみに絵を描くのが嫌すぎて、このようにコピペで使い回ししてたことがあります。でもやっぱりコピペはすごくよくわかってしまい、見るからにコピペだなという感じでした。AI だと完全に同じではなくて、ちょっと違う風に出力してくれるので、それがすごくありがたいですね。

AIありの作業プロセス

- ①プロット・ネーム

- ②コマ作成・写植

- ③生成・加筆修正

- ④トーン

- ⑤効果・描き文字等仕上げ

画像の中で文字に色をつけている部分が主に作画のプロセスです。ひたすら同じ絵を描いていたところがかなり短縮できます。

手法1: t2iでポーズや構図を任せる

作例:絵が思いつかないときも考えなくていい

1)自分絵LoRAでt2i

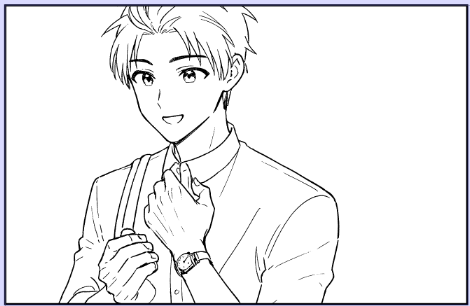

これは腕時計を見せるというコマでしたが、どんな絵を描いていいかわからなかったので「show his watch」みたいなプロンプトで生成しました。

設定

自分絵LoRAを0.6で適用しています。1に近づくとデータセットのポーズに寄ってしまうので、私のLoRAの場合は0.6前後がやりやすいです。精細さは不要なので、画像サイズは1024x1024で生成しました。

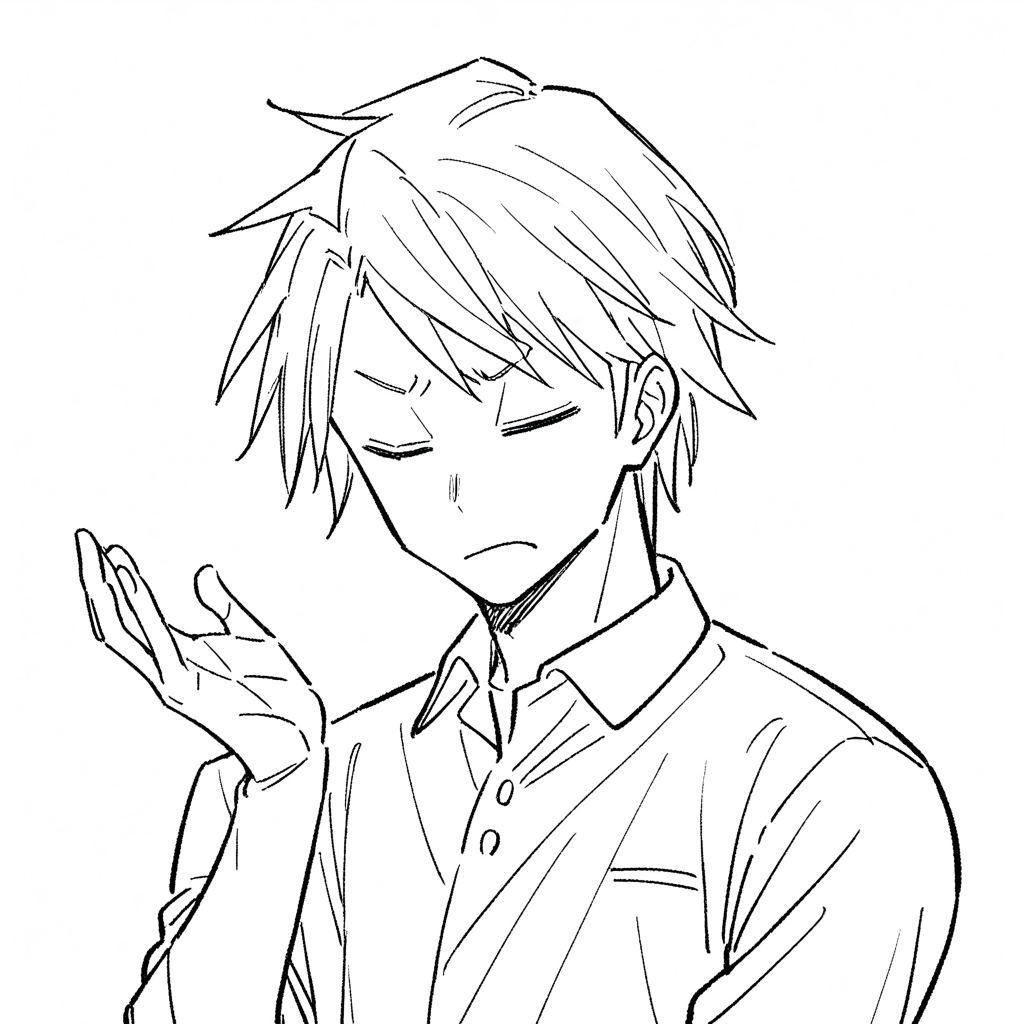

2)1をanytestで線画化して加筆修正

次にt2iで生成したものをanytestを使って線画化します。線画化する時は白紙i2iを使っています。自分絵LoRAも線画で学習したので、線画LoRAとしての効果もあります。

i2iに真っ白な画像を入力して、DenoisingStrength1で生成する手法です。プロンプトにlineart, white tone, monochromeあたりも入れておくといいかもしれません。

元画像がある場合はControlNetに入力します。

設定

プロンプト:先頭に白紙i2i用呪文(上記参照)+t2iを生成したときのものをそのまま流用。なので自分絵LoRAも0.6です。画像サイズも1024x1024でt2i時と同じです。

白紙i2iなので、i2i元には白紙を設定し、ControlNetに先ほどのt2iの生成画像を設定します。

ControlNet:プリプロセッサーはnone、モデルはanytest V4、weight0.7、Guidance End0.5で生成しました。他はデフォルト。

それから自力で加筆修正しました。まず画像サイズが1024x1024なので、拡大して二値化します。ジャケットの襟を消して、右手の向きを変えて、顔も微妙に描き換えてます。

3)人力仕上げ

手でベタやトーンなどの処理を行って完成です。

メリット:試行錯誤が減る

今回「こういうコマ」だけ決めていてどんな絵を描くか決めていませんでした。そんな時 AI がなかったら「どうしよう~~~」と何回もいろんなポーズを描いて、ああでもないこうでもないと試行錯誤していました。しかしAIで生成したら、何枚か生成した中から気に入ったのを選べばいいのですごく簡単です。

こんな時に使える:文字ネーム

この方法は文字ネームを切るタイプにはかなり有効だと思います。また私のように、どうしていいかわからないところは適当に飛ばしてしまって後で頭を抱えるタイプにもいいですね。

手法2: ラフからi2iで作画効率UP

作例:下書きをスキップできる

1)ラフ

私の場合はネームか、下描きの下描きがこれくらいのラフさです。

2)自分絵LoRA+白紙i2i+anytest

ラフをスクショしてControlNetにペーストします。適当にスクショしてもResize and Fillにしておけば何とかなります。ラフが適当すぎるのでanytestのweightは低めにしておきます。

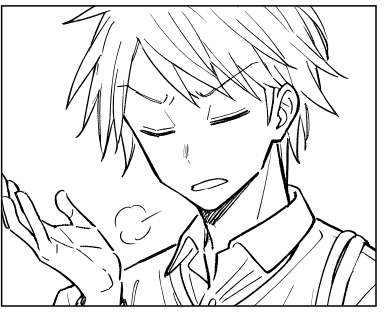

いくつか生成した中から、この2枚を選んで合成することにしました。

設定

プロンプト:ラフ絵をとりあえずi2iのところに入れてInterrogate DeepBooru(生成ボタンの下にある段ボール箱のアイコンを押す)でプロンプトを取得します。sketchが入っていれば抜いたり、少し調整します。

画像:プロンプトを取得したあとは、i2i元に入れたラフは白紙画像に差し替えます。白紙i2iなのでDenoisingStrengthは1。

ControlNet:画像にラフを入力。プリプロセッサーはnone、モデルはanytest V3(V4でいいと思います。)、weight0.45、Guidance End0.6で生成しました。この時はCrop and Resize。他はデフォルト。

3)ちょっと手で修正

雑合成して二値化後、顔などを描き直しました。このあとトーン等の仕上げをして完成です。

メリット:意図通りの絵が出せる

この絵をt2iで生成しようとした場合、プロンプトを打たないとダメだと思うんですが、言葉を考えるより絵に描いた方が速いから漫画を描いてるわけでして……。しかもどの位置に手を持ってくるかなどはプロンプトでの指示が難しいので、なおさら絵で入力した方が簡単です。

漫画制作にAIを使う場合はこのように、自分で描いた絵を入力してクオリティをあげるという生成が、現状は一番使い勝手がいいかなと思います。

こんな時に使える:同じようなコマ

先ほどコピペ戦法はいまいちだったという話をしましたが、コピペにAIをかませれば、ちょっと違う絵が出てきて良いと思います。

「もうコピペさせてくれ!」って思う同じようなコマはAIで生成しよう。(でもコピペ元を探すよりラフを描いて生成した方が速いかも)

手法3: ラフからi2iで脇役(LoRAなし)も描ける

作例:未学習キャラも描ける

1)ラフ

この画像はスクショなので他のコマとかも入っていますが、実際にi2iするときはラフのレイヤーから矩形選択で適当にコピーしてきてi2i元やControlNetにペーストしています。この画像では下描きレイヤーなので青線になってますが、コピーするときは普通のレイヤーに戻して黒線の状態でコピペします。

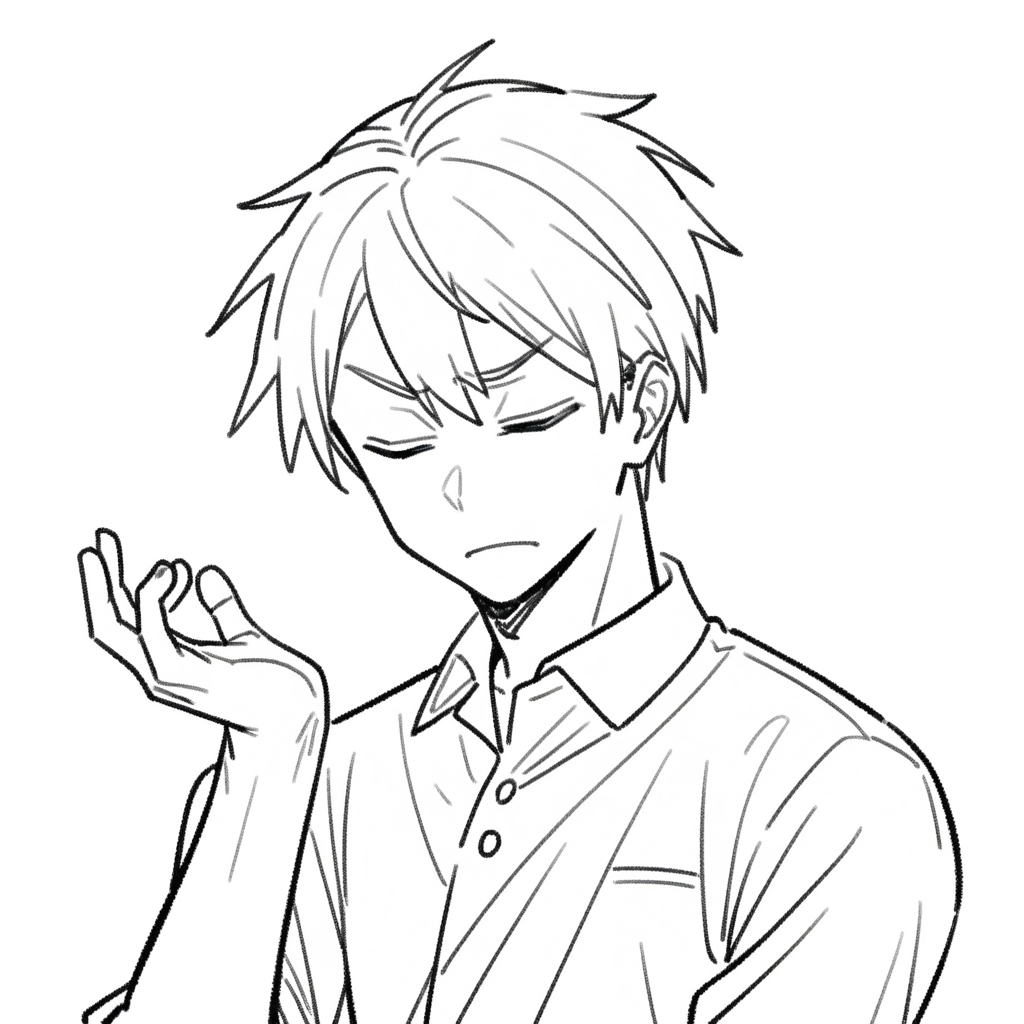

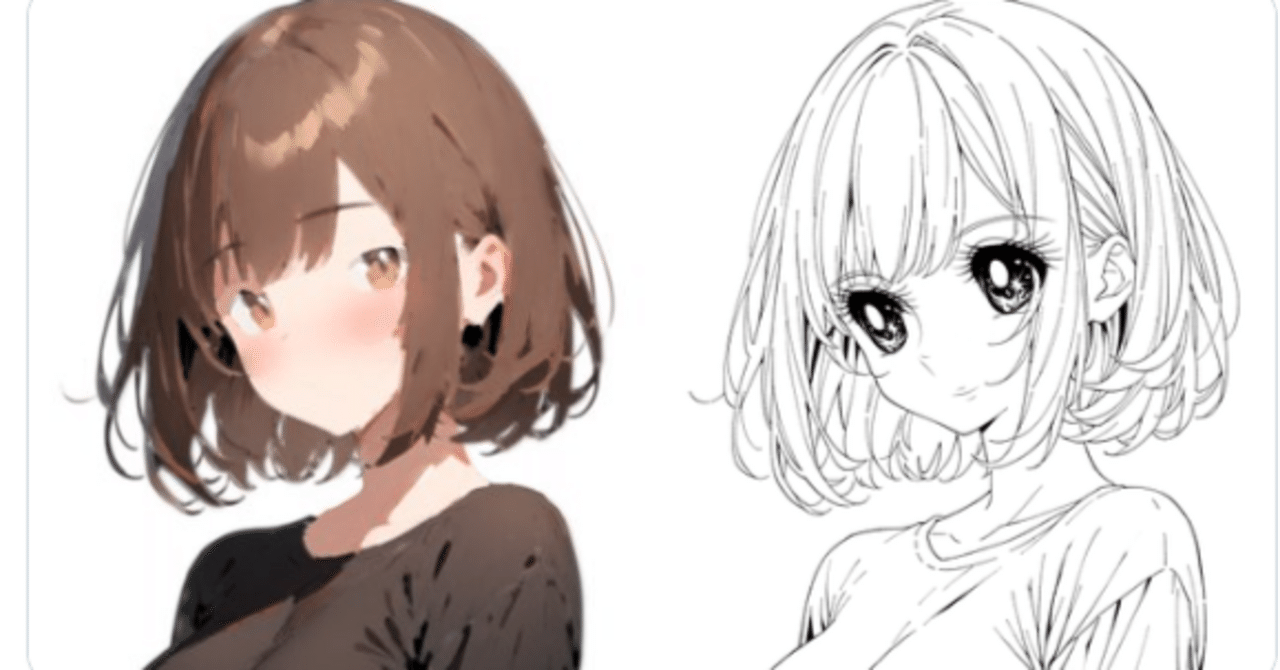

2)線画化

ラフを線画化します。今回は学習していないキャラのため、この段階では自分絵LoRAとanytestは使いません。通常のi2i(i2iにラフを入力)でsdxl-lineart_06という線画LoRAを0.5で使って線画化しました。

sdxl-lineart_06のダウンロードリンクはこちら

生成した画像のうちの1枚

生成した画像を加筆修正したもの(手は別の生成画像から合成)

設定

プロンプト:ラフ絵をとりあえずi2iのところに入れてInterrogate DeepBooru(生成ボタンの下にある段ボール箱のアイコンを押す)でプロンプトを取得します。sketchが入っていれば抜いたり、少し調整します。線画LoRAを0.5入れます。

画像:プロンプトを取得したあとは、i2i元に入れたラフは白紙画像に差し替えます。白紙i2iなのでDenoisingStrengthは1。

ControlNet:画像にラフを入力。プリプロセッサーはnone、モデルはanytest V4、weight0.45、Guidance End0.6で生成しました。この時はResize and Fill。他はデフォルト。

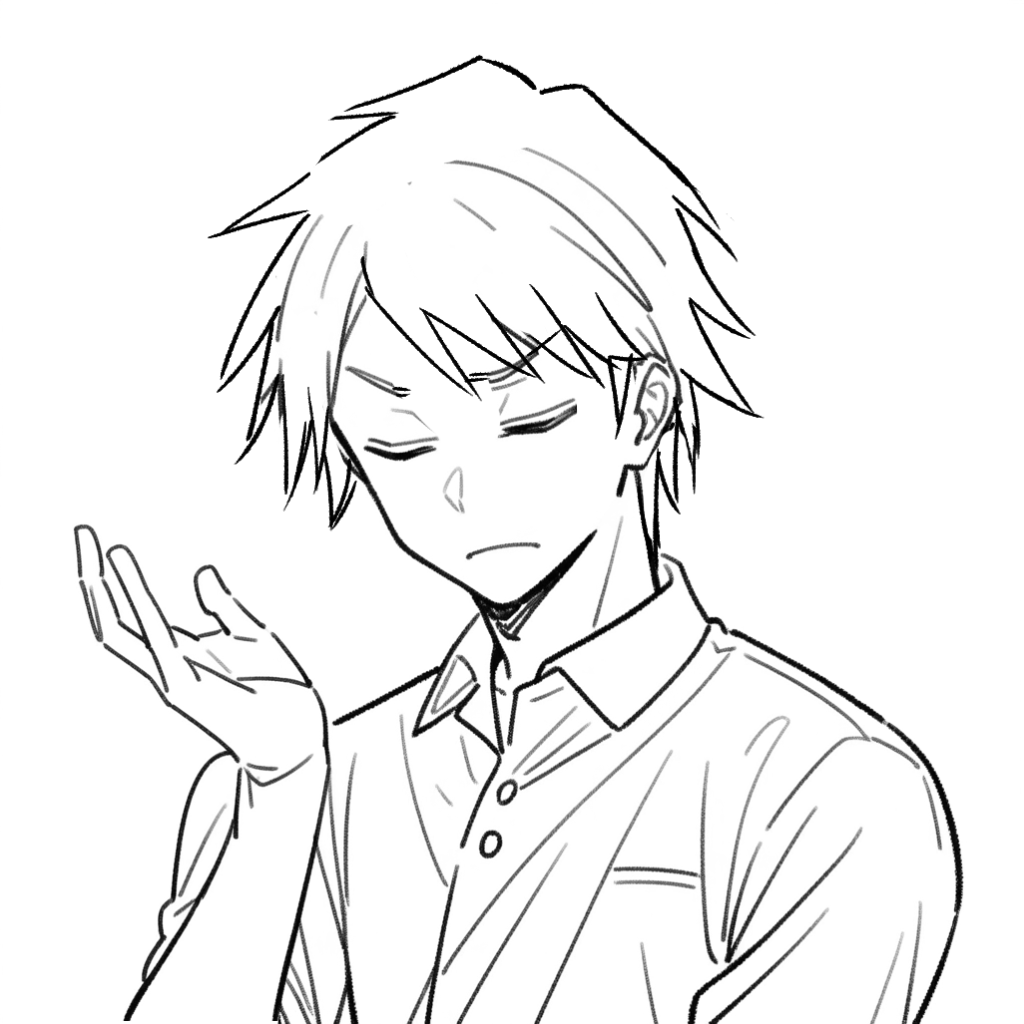

3)自分絵LoRA+白紙i2i+anytestで調整

線画化して加筆修正したものを元に、自分絵LoRAをかけます。方向性が似ているキャラをプロンプトで指定して弱めにかけます。anytestは強めにします。

生成した画像

生成した画像を加筆修正したもの

設定

プロンプト:さっきのプロンプトを流用して、線画LoRAの部分だけ自分絵LoRA0.6に書き換え。

画像:白紙i2iなのでDenoisingStrengthは1。

ControlNet:画像にラフを入力。プリプロセッサーはnone、モデルはanytest V4、weight0.75、Guidance End0.6で生成しました。他はデフォルト。

メリット:学習しなくていい

この方法だと学習しなくても、ある程度は自分の絵に寄せて(というか別キャラに寄せて…になりますが。)生成することができます。

こんな時に使える:数コマしか出ないキャラ

通常のLoRA学習には10枚以上は教師データが必要です。でも脇キャラの場合は、小さなコマや引きの絵が多くて学習に向かない場合が多くないでしょうか?データセットの準備等、学習するのも何やかんや時間がかかるので、ちょっとしたコマならこれでいいかなと思います。

ただ、今はCoppyLora_WebUIにV2からDetailTrainモードが搭載されたこともあり、コピー機学習が簡単にできるようになってます。なので、ちょっとしか出ないキャラでも学習してしまってもいいかも。

CoppyLora_WebUI_V2についてはこちら

AIと手描きのハイブリッド制作の可能性

とにかく疲れが軽減される

再三述べていますが、手描きとAIを組み合わせることで絵を描く労力が減り、かなり体力の消耗を防げます。それに脳の疲れも格段に減ります。この、脳を使うことが絵を描く楽しさかもしれないですが、 楽しいだけじゃない絵を描く必要がある人には一度AIの活用を試してみて欲しいなと思います。

絵で指示できるのは自分で描けるからこそ

単にAIだけで漫画を作ろうとしたとき、t2iだとプロンプトを考える必要があります。でも自分で絵が描けるなら、言葉で考えるより絵で指示を出した方が便利かも。特に漫画では「動作の途中」を描くことも多く、そういうポーズは画像を入力した方が手っ取り早く、意図を反映しやすいです。あと視線誘導やフキダシと絵の位置関係のことを考えると、絵で指示した方が絶対いいと思う。

今後挑戦したいこと

背景は3Dに頼っているので、これもAIを使えればいいなあと思います。構造や物の配置、一貫性などはAIより3Dの方が断然優れているので、簡素な3Dモデルを作ってAIで描きこみを増やす方向がいいかな?なかなか時間が取れてないですが、ぼちぼちやっていきたいと思いますので、来年もよろしくお願いします。よいお年を!(ちょっと早い)

2024/12/28:生成時の設定などを追加しました。